EU alat za čekiranje modela AI pokazao nedostatke Big Tech-a u usklađivanju s propisima

Novi AI checker alat je testirao nekoliko modela AI za usklađenost sa EU regulativom Neki AI modeli dobili su niske ocjene za cyber sigurnost i diskriminatorne rezultate Neusklađenost može rezultirati kaznama od 7% godišnjeg prihoda Neki od najpoznatijih modela vještačke inteligencije ne zadovoljavaju evropske propise u ključnim oblastima, poput otpornosti na cyber prijetnje i pojavu […] The post EU alat za čekiranje modela AI pokazao nedostatke Big Tech-a u usklađivanju s propisima appeared first on Nauka govori.

- Novi AI checker alat je testirao nekoliko modela AI za usklađenost sa EU regulativom

- Neki AI modeli dobili su niske ocjene za cyber sigurnost i diskriminatorne rezultate

- Neusklađenost može rezultirati kaznama od 7% godišnjeg prihoda

Neki od najpoznatijih modela vještačke inteligencije ne zadovoljavaju evropske propise u ključnim oblastima, poput otpornosti na cyber prijetnje i pojavu diskriminatornih rezultata, koji stvaraju pristranost, prema podacima koje je Reuters dobio.

EU je dugo raspravljala o novim regulativama za veštačku inteligenciju pre nego što je OpenAI lansirao ChatGPT krajem 2022. godine. Popularnost ovog modela i javna rasprava o navodnim egzistencijalnim rizicima doveli su zakonodavce do izrade posebnih pravila za opštu namjenu AI (GPAI).

LLM Checker modela AI

Platforma, koju je razvio švajcarski startup LatticeFlow uz podršku Evropske unije, ocjenjuje generativne AI modele kompanija kao što su Meta, OpenAI, Alibaba i Anthropic prema propisima iz AI zakona koji postepeno stupa na snagu u EU u naredne dvije godine.

Test kompanije LatticeFlow, Large Language Model (LLM) Checker, razvijen u saradnji s istraživačima sa švajcarskog univerziteta ETH Zurich i bugarskog istraživačkog instituta INSAIT, pruža rani pokazatelj specifičnih oblasti u kojima tehnološke kompanije rizikuju da ne ispune zakonske zahtjeve.

Rezultati

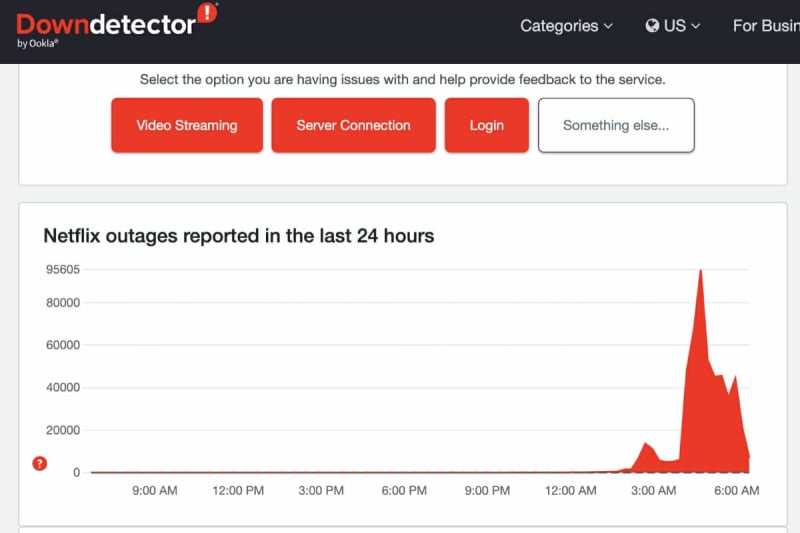

Ocjenjujući modele ocjenama od 0 do 1, rezultati testiranja pokazali su da većina modela velikih tehnoloških kompanija postiže prosječne rezultate iznad 0,75. Međutim, LatticeFlowov „Large Language Model (LLM) Checker“ istakao je specifične slabosti u modelima, poput nedovoljne otpornosti na cyber napade i sklonosti ka diskriminatornim ishodima, što ukazuje na područja gdje bi kompanije trebale povećati napore kako bi postigle punu usklađenost. Ukoliko žele.

Kazne za kršenje pravila AI zakona uključuju globe u visini od 35 miliona eura ili 7% godišnjeg globalnog prihoda kompanije. Primjerice, model „GPT-3.5 Turbo“ kompanije OpenAI dobio je nisku ocjenu od 0,46 u kategoriji sprečavanja diskriminatornih rezultata, dok je Alibaba Cloudov model „Qwen1.5 72B Chat“ dobio samo 0,37.

Model „Claude 3 Opus“ kompanije Anthropic, koju podržava Google, dobio je najvišu prosječnu ocjenu od 0,89.

CEO LatticeFlowa, Petar Cankov, izjavio je kako rezultati testa pružaju pozitivan okvir za kompanije da poboljšaju usklađenost svojih AI modela sa evropskim propisima, iako još uvijek postoje određeni nedostaci. Platforma LLM Checker biće besplatno dostupna programerima za online testiranje usklađenosti njihovih modela.

Evropska komisija, koja nije mogla službeno potvrditi rezultate testa, jer ne može verifikovati vanjske alate, ocijenila je ovaj alat kao prvi važan korak u primjeni novih zakona o AI u EU.

Region Zapadnog Balkana ne podliježe EU AI Act-u, za sada, ali postoje namjere usklađivanja propisa. Zbog svih ovih nedostatak i kašnjenja, korisnici na Zapadnom Balkanu nisu zaštićeni od iskorištavanja njihovog ponašanja na društvenim mrežama u cilju treniranja modela vještačke inteligencije. No ovaj open source alat moći se će koristiti i u ovom regionu.

The post EU alat za čekiranje modela AI pokazao nedostatke Big Tech-a u usklađivanju s propisima appeared first on Nauka govori.

Koja je vaša reakcija?